أظهرت دراسة قام بها باحثون في جامعة جورج ماسون الأميركية، أنّ الناس مستعدون للتسامح مع الأكاذيب البيضاء للإنسان الآلي، لكنهم أقل تسامحًا في حالة محاولة هذه الأجهزة إخفاء قدراتها الحقيقية أو ممارسة الرقابة عليهم.

شملت الدراسة نحو 500 شخص لسؤالهم عن وجهة نظرهم بشأن سيناريوهات افتراضية يتم فيها استخدام الإنسان الآليّ في مجالات مثل الرعاية الصحية وتجارة التجزئة ونظافة المنازل.

وأظهرت أنّ الناس يميلون غالبًا إلى تقبّل كذب الإنسان الآلي إذا كان ذلك "لحماية المريض من ألم غير ضروري" من خلال إخفاء جزء من الحقيقة عنه.

في المقابل، اعتبر أغلب المشاركين في المسح، أنّ السيناريو الذي يقوم فيه الإنسان الآليّ بتصويرهم خلسة ومن دون علمهم غير مقبول بالنسبة لهم.

وقال بعض المشاركين إنّ تجسس الإنسان الآلي "لأغراض أمنية" يمكن أن يكون مقبولًا.

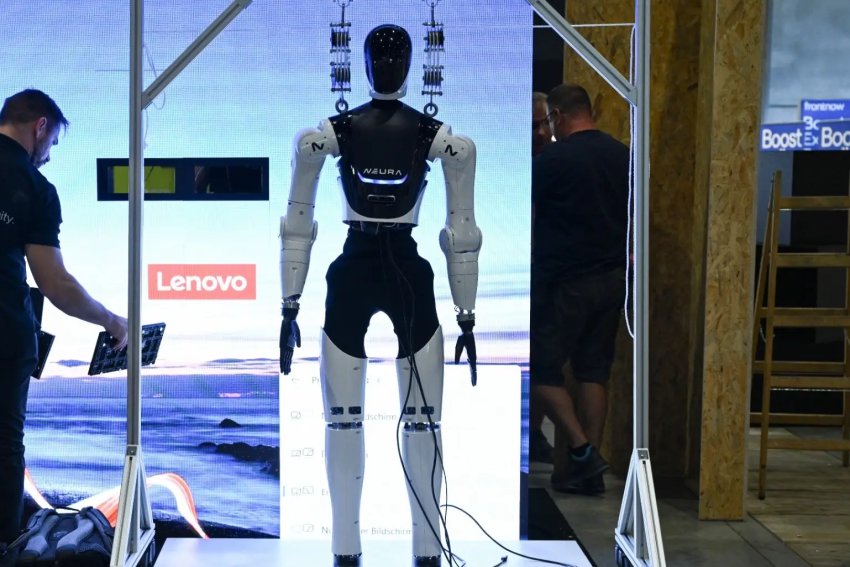

يأتي ذلك في الوقت الذي انتشر فيه استخدام أنظمة الإنسان الآلي في مجالات عدة خلال الأعوام العشرة الماضية، حيث أصبحت تقوم بأعمال أكثر تعقيدًا وبتكلفة مقبولة.

أنماط سلوكية

وفي الشهر الماضي، قال محللون في بنك الاستثمار الأميركيّ مورغان ستانلي، إنّ ظهور الذكاء الاصطناعيّ مع الإنسان الآلي، يمكن أن يؤدي إلى إنتاج أجهزة "شبيهة بالبشر"، وبالتالي تؤدي إلى فقدان ملايين الأشخاص لوظائفهم خاصة في قطاعات مثل الزراعة والتشييد.

ويقول أندريس روزيرو من جامعة جورج ماسون، "مع قدوم الذكاء الاصطناعيّ التوليدي، أشعر بأهمية فحص حالات محتملة لاستخدام تصميم بشريّ الشكل وأنماط سلوكية للتلاعب بالمستخدمين.

وتبيّن أنّ أنظمة الذكاء الاصطناعيّ تنتج ما يسمى بـ"الهلاوس"، أو تقدم استجابات غير دقيقة أو مضللة لأسئلة المستخدم.

ونشر معهد ماساشوستس للتكنولوجيا (إم.آي.تي) مؤخرًا دراسة أظهرت افتقاد عمليات تدريب منصات الذكاء الاصطناعي، أو نماذج اللغة الكبيرة للشفافية في أغلب الحالات.

وقال روزيرو، "نرى بالفعل نماذج لشركات تستخدم مبادئ تصميم اٌلإنترنت ومنصات محادثة الذكاء الاصطناعيّ بطرق تستهدف التلاعب بالمستخدمين ودفعهم نحو تصرف محدد".

(د ب أ)