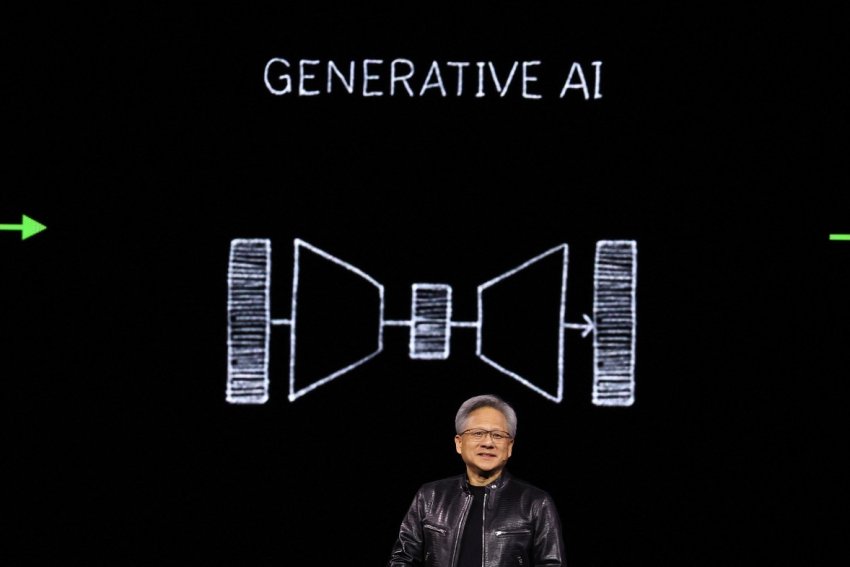

في خطوة جديدة ترفع من منسوب الاهتمام بالشركة، أعلنت صانعة الرقائق الالكترونية Nvidia، الاثنين، عن جيل جديد من الرقائق المدمجة ببرامج الذكاء الاصطناعي، ستجعل كبريات الشركات التكنولوجية يلجأون إليها.

ويأتي هذا الإعلان، الذي صدر خلال مؤتمر مطوري Nvidia في سان خوسيه، في الوقت الذي تسعى فيه شركة تصنيع الرقائق إلى تعزيز مكانتها كمورد رئيسي لشركات الذكاء الاصطناعي.

ارتفع سعر سهم Nvidia بمقدار خمسة أضعاف وتضاعف إجمالي المبيعات بأكثر من ثلاثة أضعاف منذ أن أطلق ChatGPT من OpenAI طفرة الذكاء الاصطناعي في أواخر عام 2022. تعد وحدات معالجة الرسومات للخادم المتطورة من Nvidia ضرورية لتدريب ونشر نماذج الذكاء الاصطناعي الكبيرة.

وفي هذا المجال، أنفقت شركات مثل Microsoft وMeta مليارات الدولارات لشراء الرقائق.

ما هي المنتجات الجديدة؟

يُطلق على الجيل الجديد من معالجات الرسوميات، التي تعمل بتقنية الذكاء الاصطناعي، اسم Blackwell.

وتسمى شريحة Blackwell الأولى GB200 وسيتم شحنها في وقت لاحق من هذا العام.

ولتحفيز الطلبات الجديدة، تقدم شركة Nvidia لعملائها شرائح أكثر قوة. على سبيل المثال، لا تزال الشركات وصانعو البرمجيات يسعون جاهدين للحصول على الجيل الحالي من رقائق "Hopper" H100 والرقائق المماثلة.

وتحدث الرئيس التنفيذي لشركة Nvidia جنسن هوانغ Jensen Huang، خلال مؤتمر مطوري الشركة في كاليفورنيا، قائلاً: "إن Hopper رائع، لكننا بحاجة إلى وحدات معالجة رسوميات أكبر".

قدمت الشركة أيضاً برنامجاً سيعود عليها بدخل أكبر يسمى NIM والذي سيسهل نشر الذكاء الاصطناعي، مما يمنح العملاء سبباً إضافياً للاستمرار في استخدام شرائح Nvidia في ظل هجمة الشركات الناشئة على المنافسة في مجال تصنيع الشرائح.

يقول المسؤولون التنفيذيون في شركة Nvidia إن الشركة أصبحت أقل من مجرد مزود شرائح، وأكثر من مجرد مزود منصات، مثل Microsoft أو Apple، حيث يمكن لشركات أخرى بناء البرامج عليها.

وقال هوانغ: "إن بلاكويل ليست شريحة، بل هي منصة".

قوة في الآداء مدعومة بالذكاء الاصطناعي

تقوم Nvidia كل عامين بتحديث بنية وحدة معالجة الرسومات الخاصة بها، مما يفتح قفزة كبيرة في الأداء. تم تدريب العديد من نماذج الذكاء الاصطناعي التي تم إصدارها خلال العام الماضي على بنية Hopper الخاصة بالشركة، والتي تستخدمها شرائح مثل H100، والتي تم الإعلان عنها في عام 2022.

أما بالنسبة إلى الشرائح الجديدة، تقول Nvidia إن المعالجات المستندة إلى Blackwell، مثل GB200، تقدم ترقية هائلة للأداء لشركات الذكاء الاصطناعي، مع 20 بيتافلوب في أداء الذكاء الاصطناعي مقابل 4 بيتافلوب لـ H100. وقوة المعالجة الإضافية ستمكن شركات الذكاء الاصطناعي من تدريب نماذج أكبر وأكثر تعقيداً.

تتضمن الشريحة ما تسميه Nvidia محرك المحولات المصمم خصيصاً لتشغيل الذكاء الاصطناعي، وهي إحدى التقنيات الأساسية التي يقوم عليها ChatGPT.

وتُعد وحدة معالجة الرسومات Blackwell كبيرة الحجم حيث تجمع بين قالبين تم تصنيعهما بشكل منفصل في شريحة واحدة تصنعها شركة TSMC. وسيطرح في الأسواق، أيضاً خادم كامل يسمى GB200 NVLink 2، يجمع بين 72 وحدة معالجة رسوميات Blackwell وأجزاء Nvidia الأخرى المصممة لتدريب نماذج الذكاء الاصطناعي.

لم تُفصح Nvidia عن تكلفة لـ GB200 الجديد أو الأنظمة المستخدمة فيها. ولكن وفقاً لتقديرات المحللين، تتراوح تكلفة H100 المستندة إلى Hopper من Nvidia بين 25000 دولار و40000 دولار لكل شريحة، مع أنظمة كاملة تكلف ما يصل إلى 200000 دولار.